Find 命令

Cheat sheets

仅查找第一层子目录内容,不处理第二层及以下子目录

find . -mindepth 2 -maxdepth 2

使用 -path 条件查找相对路径 . 目录下的 app.json 文件和子目录 conf 中的所有 json 文件

find . -maxdepth 2 -path './app.json' -o -path './conf/*.json'

使用 -path 条件查找绝对路径 /opt/foo 目录下的 app.json 文件和子目录 bar 下的所有 json 文件

find /opt/foo -maxdepth 2 -path '*/foo/app.json' -o -path '*/foo/bar/*.json'

Bash Redirections

Bash 重定向

当 Bash 启动的时候,它会打开三个标准文件描述符 (File Descriptor)

/dev/stdin- file descriptor 0/dev/stdout- file descriptor 1/dev/stderr- file descriptor 2

除非你将文件描述符关了,否则它总是指向某个文件。通常 Bash 启动的这三个文件描述符,stdin, stdout 和 stderr 会指向你的终端。从终端读取输入,也输出到终端。

GNU Less 常用设置

macOS 可以使用 brew install less 安装最新的 GNU Less.

GNU Less 常用的选项

# set options for less

export LESS='--quit-if-one-screen --ignore-case --status-column --LONG-PROMPT --RAW-CONTROL-CHARS --HILITE-UNREAD --tabs=4 --no-init --window=-4'

# short version

export LESS='-F -i -J -M -R -W -x4 -X -z-4'

macOS 常用命令行工具

在 macOS/OS X 上安装和使用 GNU 命令行工具

macOS 系统默认使用 BSD 版本的命令行工具,这与 Linux 系统的命令行工具不同,但这两个版本都符合 POSIX 标准。我们可以使用 Homebrew 安装 GNU 命令行工具。

brew install coreutils

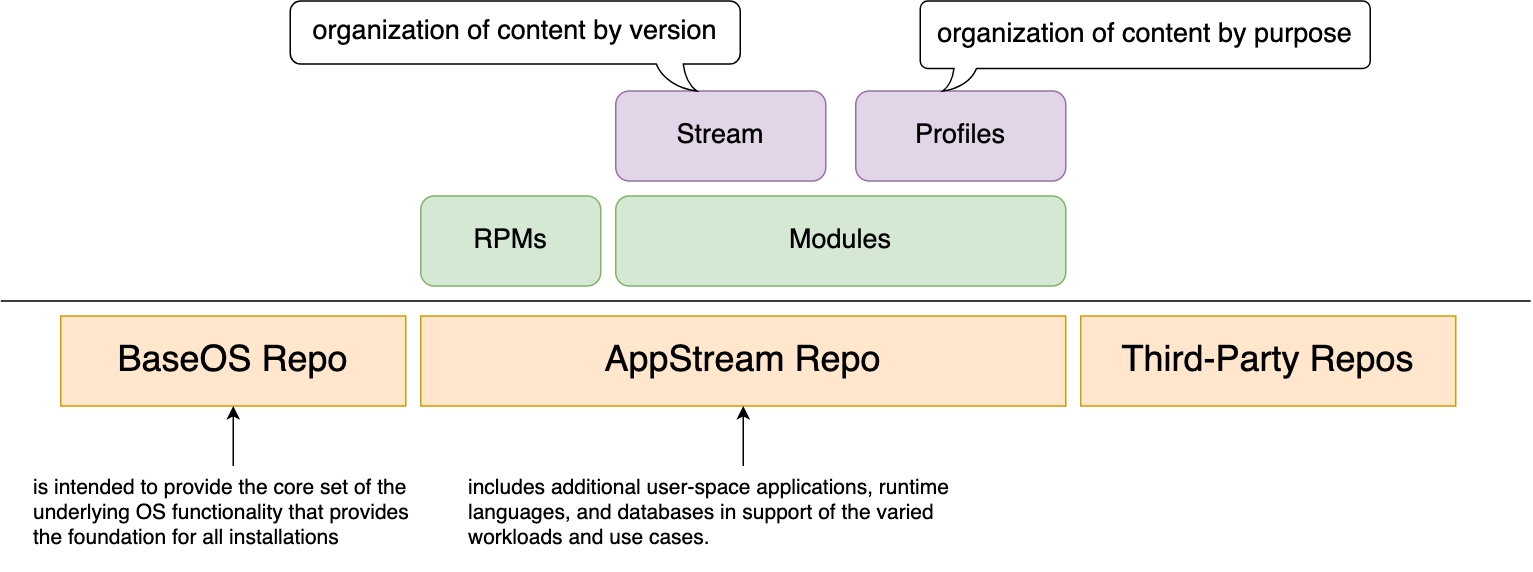

Linux System Provision

不同的 Shell 类型

参考以下三个问题的回答:

- Difference between Login Shell and Non-Login Shell?

- What is the difference between interactive shells, login shells, non-login shell and their use cases?

- What should/shouldn’t go in .zshenv, .zshrc, .zlogin, .zprofile, .zlogout?

Login shell

Login shell 是在用户登录后创建的第一个进程,该进程读取以下文件来设置环境变量:

- Bourne shell:

/etc/profile,~/.profile - Bash:

/etc/profile,~/.profile,~/.bash_profile - Zsh:

/etc/zprofile,~/.zprofile - Csh:

/etc/csh.login,~/.login

之后其它的 shell 都是由这个 login shell 或其子孙 fork 出来,这些子孙 shell 会继承 login shell 的许多设置 (例如环境变量,umask 等)。

English Understanding

关于 Receive 和 Retrieve

A common spelling rule in English for the sequence of “i” and “e” is often stated as:

- “i before e except after c,” meaning that “ei” is commonly used after the letter “c.”

For example, in the word “receive,” the “c” is followed by the “ei” combination. On the other hand, in the word “retrieve”, since there is no “c” before it, you should use “ie.”

English Common Used Phrases

常用短语及单词。

常用口语

-

Hey, How’s it going? Pretty good.

Howzit goin’? Priddy good. -

Do you want to go?

Joo Wanna go? -

I’m not sure.

I’m no’ shur. -

You gotta try it.

You godda try i’. -

Thanks! I appreciate it.

I a-prish-e-a’e i’.

共计 114 篇文章,3 页。